基于语音的说话人认证技术(声纹识别技术)属于生物特征识别研究范畴,在互联网/物联网时代具有重要的应用价值。目前,限定条件下的说话人身份认证技术已较为成熟,在智能手机、银行服务、门禁控制和智能客服等场景获得了广泛的应用。然而,作为智能控制场景中实现基于语音的自然人机交互的关键技术,短语音说话人身份认证技术目前尚不能满足应用需求。本文将重点对短语音说话人确认技术的研究进行技术综述。首先,概述说话人确认技术的基本概念和主流技术路线;其次,分析短语音说话人确认技术面临的挑战;然后,对基于深度学习的说话人确认技术进行综述;最后,展望了短语音说话人确认技术的发展趋势和应用前景。

1 引言

人类之所以能够”闻其声而知其人”,是因为每个说话人都有不同的说话方式和用词习惯,以及略有差异的发声器官生理结构,这两点导致不同说话人在声音上各具特点,具有不同声纹信息。基于语音的说话人确认是利用计算机分析和提取语音中蕴含的说话人信息来自动进行说话人身份认证的技术,是自然人机交互的重要技术之一,也是智能机器人的关键技术,具有重要的研究价值。

说话人确认技术目前广泛应用于各类具有身份认证需求的领域,例如:在智能家居领域,说话人确认技术能帮助智能设备确认说话人的身份,使得智能系统能对于不同说话人提供定制化服务和内容;在金融领域,说话人确认技术可以用于基于网络交易的远程身份认证,进而提高金融账户的安全性,并降低基于互联网的金融犯罪成功率;在公安司法领域,可以用于电信诈骗犯的身份侦查,从而帮助公安有效遏制并打击犯罪。具体而言,公安人员可以利用说话人确认技术,先从电话录音中截取目标说话人的语音数据,再匹配说话人数据库,最终锁定犯罪嫌疑人。使用先进的说话人确认技术可以降低办案成本,提高破案率。

说话人确认技术的研究开始于20世纪30年代,早期研究人员的工作主要集中在人耳听辨,模板匹配等方向;随着统计学和计算机科学的发展,说话人确认的工作开始转向语音特征提取和模式匹配等方法研究;近年随着人工智能的崛起和计算能力的提升,基于机器学习和深度学习的说话人确认技术逐渐成为主流。

本文将首先介绍说话人确认的基本概念,其次从特征提取和短语音建模两个角度,对智能语音控制场景下的短语音说话人确认技术的发展历程进行简要回顾,然后分析几类运用深度学习的短语音说话人确认技术,最后对发展趋势做出总结与展望。

2 说话人确认技术综述

说话人确认(SpeakerVerification)技术,如图1所示,是确定待识别的语音是否来自其所宣称的目标说话人[1][2],是“一对一”的判决问题。具体而言,说话人确认任务可以分为训练,注册,验证三个阶段。在训练阶段:利用大量的数据训练说话人通用模型;注册阶段:采集注册说话人的少量语音数据并通过算法获得注册说话人的声纹模型;验证阶段:输入声称为目标说话人的测试语音并计算对应的说话人模型,再与已经注册的目标说话人模型进行匹配,最终判定其身份是否为已注册的目标说话人。

图1说话人确认概念示意图

2.1文本相关和文本无关

根据说话人确认技术对语音的文本信息是否予以限制,可以将说话人确认技术分为文本无关的(text-independent)和文本相关的(text-dependent)。

文本无关的说话人确认技术:训练模型时不限定所采用语音数据的文本信息,且训练语音和测试语音的文本内容不要求一致,即说话人可以随意说任意语句。

文本相关的说话人确认技术:模型训练时所采用语音数据的文本内容预先固定在某一个特定的范围内,并要求训练语音和测试语音的文本内容保持一致。

2.2说话人确认技术性能评测

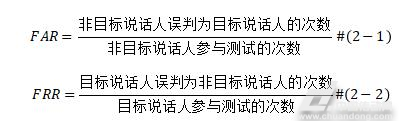

衡量说话人确认技术性能的两个基本指标是:错误接受率(FalseAcceptationRate,FAR)和错误拒绝率(FalseRejectionRate,FRR),其定义如下:

其中,FAR表示将非目标说话人的语音经说话人确认系统,其相似度得分大于给定的阈值,从而被判断为目标说话人的错误率。FAR的值越小,表示系统将非目标说话人错误识别成目标说话人的概率越低,系统的性能就越好。当处于需要实现快速访问,对于准确度的要求不高的日常生活中,说话人确认系统可以设定稍高的FAR值。

另一方面,FRR表示将目标说话人语音经说话人确认系统的得分低于设置的阈值,被系统判断为非目标说话人的错误率。可以看出,FRR的值越小,系统将目标说话人误识为非目标说话人的概率越低,系统的性能越好;在需要高安全性的商业场景中,说话人确认系统可设定稍高的FRR值,以牺牲访问速度为代价,换取更高的系统安全性。

根据FAR和FRR,可拓展得到三个常用的说话人确认系统性能评价指标。

(1)等错误率(EER)

在说话人确认系统效能评测中,FAR随着阈值的增大而减少,FRR随阈值的增大而增大。目前国际竞赛中最常用的测评指标是将FAR和FRR统一为一个指标。即取两者相等时的错误率作为衡量说话人确认算法的性能指标,该错误率称为等错误率(EqualErrorRate,EER)。在EER指标中,FAR和FRR被赋予相同的权重,即认为他们对系统影响的权重是相同的。

对于不同的说话人确认算法而言,较低的EER值,意味着FAR和EER曲线都会向下移动,表示算法的性能较优秀。

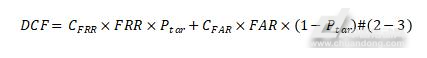

(2)最小检测代价

美国国家标准及技术研究所(NationalInstituteofStandardsandTechnology,NIST)在其举办的说话人确认评测(SpeakerRecognitionevaluation,SRE)竞赛中定义了一个利用FAR和FRR加权和来衡量说话人确认系统性能的指标,即检测代价函数(DetectionCostFunction,DCF)[3]。DCF定义如下:

其中,CFRR表示错误拒绝的权重系数,CFAR表示错误接受的权重系数;这些参数的值在比赛中由NIST官方给定,针对不同的任务,每届比赛中这些参数的值不尽相同;在实际应用中,这些权重参数值可以根据具体的应用场景进行设定。DCF的值取决于判决阈值,改变判决阈值就可以使得DCF的值达到最小,就形成了最小检测代价(minDCF)。

相较于EER,minDCF考虑了两种不同错误率带来不同的代价,因此在实际应用中更加合理,可以更好地评价说话人确认系统的性能。

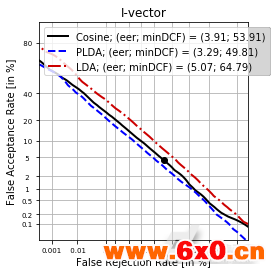

(3)DET曲线

说话人确认系统中,可以根据不同的应用场景设置不同的阈值,对FAR和FRR进行取舍,实际应用中一般采用DET曲线(DetectionErrorTrade-offCurve,DETCurve)来表示FAR和FRR随阈值变化关系的曲线。如图2展示的是i-vector系统[4]采用不同后端打分模型所对应的DET曲线,从DET曲线可以直观地看出不同后端打分函数后说话人确认算法的性能差异。显然DET曲线离原点越近系统的性能越好。此外,DET曲线中的变化是一种阶梯状的阶跃函数,当测试数据集足够多的时候,DET曲线才能显示出较平滑的斜率。

图3DET曲线

3 主流短语音说话人确认技术综述

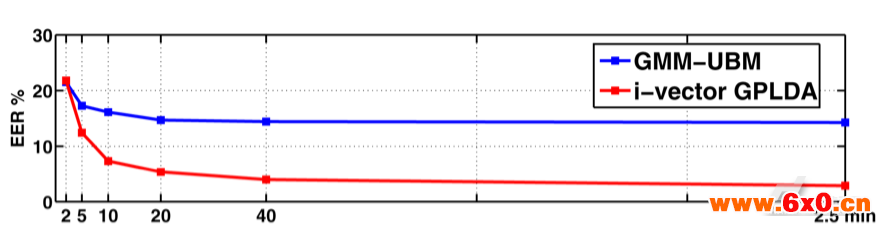

说话人确认技术经过近80年的发展,在辨识能力,鲁棒性和模型表达能力上都取得了一些令人瞩目的成绩。在安静条件下的长时说话人确认技术已经可以满足商用需求。实际应用中,研究人员发现说话人语音的长短对于说话人确认系统有较大的影响[5][6],主流的说话人确认技术在测试语音时长较短(小于3秒)的条件下,其性能有较大的波动。图3显示了高斯混合-通用背景模型(GaussianMixtureModel-UniversalBackgroundModel,GMM-UBM)[7]系统和ivector-GPLDA[8]系统当语音时长从150秒缩短为2秒间[9],EER的变化情况。可见说话人确认系统随着训练和测试数据中语音持续时间的变短而急剧下降。针对这个问题,研究者们开始将说话人确认技术的研究重点转向短语音条件下的说话人确认技术。

图3说话人确认系统性能随不同语音时长的变化

3.1语音控制场景下短语音说话人确认技术的挑战

一般而言,短语音说话人确认常见于智能家居,智能机器人等智能语音控制场景。对于智能语音控制场景下的短语音说话人确认技术,其短语音指的是,说话人的注册和验证的语音内容均为时长较短的词语,比如:“开门”、“关门”等,时长短于3秒的语音。考虑具体应用场景,采集的语音信号混合了其他说话人、环境噪音、信道失配等干扰信息。对于短语音说话人确认技术的难点,总结如下:

(1)时长短:说话人注册和测试的语音时长较短,通常仅仅只包含几个字,比如:“开窗”,”关灯”等。这些语句中包含的有效语音信息较少,且说话人信息不充足[10],可能使得训练和测试时匹配度下降,进而使得说话人确认系统表现较差。

(2)噪声干扰问题:实际应用中,环境背景噪声将会对说话人确认结果造成非常大的干扰,噪声将会导致目标说话人语音中混入大量的不确定信息,进而使得参数模型难以估计准确统计量,最终严重降低说话人确认系统的性能[11]。

(3)无效录音:在实际场景中采集语音数据时,测试集和训练集中的语音不可避免的混入无效语音,这使得有用语音的时间进一步变短,不足以提供足够的信息来训练模型。对于传统的说话人统计模型,这将使模型的后验协方差变大[12][13],系统估计的不确定性上升。

3.2短语音说话人确认技术

由于短语音包含信息有限,不能沿袭传统的长时说话人确认技术路线,需要寻找更适合短语音的特征表示,并对短语音进行合理建模或补偿。

3.2.1特征提取

传统长时说话人确认方法多采用梅尔倒谱滤波器系数(MelFilterCepstralCoefficient,MFCC)作为输入特征,但对于短语音说话人确认,因为语音中的不确定性往往不能忽略,所以基于MFCC和传统i-vector的方法难以估计准确的说话人表征,导致识别率较差[14]。为了克服这一问题,有研究者提出采用多特征融合的方法,利用不同特征包含不同信息的特性,弥补短语音的缺陷。在数据量有限的文本无关说话人确认场景下,选取对语音上下文信息变化不敏感的特征进行融合[15]。初期研究者们尝试了利用LPCC,LSF,PLP和PARCOR(Partialcorrelationcoefficients)[16][17][18]等短时频谱特征进行融合,来提升短语音说话人确认系统的性能。近年,Todisco[19]提出了一种更能表征说话人信息的新特征,称为CQCC(constantQtransformcoefficients),通过模拟人的听觉感知系统,引入常数Q因子,使得生成的频谱图在高频和低频都具有较高的分辨率,同MFCC特征相比更适合短语音说话人确认任务。此外,Leung等[20]利用语音上下文的关联性,提出了基于N-gram语言模型的短语音说话人确认的方法。Penny等[21]提出将音素后验概率信息转换为特征的方法,利用语音识别得到音素后验概率信息,辅助训练UBM。Fu[22]则使用串联特征(Tandemfeature)方法,即串联短时频谱特征和基于语音识别深度网络的特征,在基于GMM-UBM的框架下取得了较高的识别率。Sainath[23]采用自编码器的结构,将网络的某个隐藏层设置为瓶颈层(Bottlenecklayer),将瓶颈层的输出和其他特征串联,实验表明该方法有助于提升短语音说话人确认系统性能。

3.2.2短语音建模

近年随着i-vector框架成为说话人确认的基准(benchmark),研究者也展开了基于i-vector框架的短语音说话人确认研究。由于PLDA的框架可以适用于任意语音长度的说话人确认[24],因此,许多研究者开始了基于i-vector-PLDA框架下对短语音说话人确认技术的探索。其中模式匹配和归一化是近年的研究热点。

Jelil等[25]提出了在文本相关的短语音说话人确认中使用语音中隐含的音素序列信息的方法,分别构建了说话人相关的GMM和特定短语的高斯后验概率图,在测试阶段,一方面需要比较目标说话人的GMM,另一方面,也要利用动态时间规整(DTW)方法与特定短语模板后验图匹配;Dey等[26]则尝试在在基于DNN和i-vector框架下通过DTW引用序列信息,来提升文本相关短语音说话人确认性能。

归一化方法主要用于补偿训练、注册及测试过程中语音时长不匹配造成的影响。Hautamäki等人[12]提出基于minimax策略提取i-vector向量以表征说话人,在使用EM算法提取Baum-Welch统计量时引入minimax方法帮助模型获取更加鲁棒的i-vector;2014年,Kanagasundaram等[27][28]发现模型估计同一说话人多条短语音的i-vectors有明显差异,他们假设这种差异来源于i-vectors所包含的不一致的音素信息,因为短语音中包含的词汇少、覆盖的音素少,因此包含的说话人信息有限,在该假设的基础上,他们提出短语音方差规整(Shortutterancevariancenormalization,SUVN)的方法来补偿失配音素内容。Hasan等[29]在统计时长和音素数量的关系时发现,当语音时长变短时,一句话中可检测到的音素数量呈指数趋势下降,基于这个发现,他们将时长差异视为i-vector空间的噪声,并对其建模,提高了说话人确认系统在短语音条件下的性能。

2013年后基于深度学习的方法也被引入,在DNN框架下,Snyder等人[30]利用时序池化层(temporalpoolinglayer)处理变长语音输入;长时说话人确认中语音的i-vectors还可以学习到短语音下的音素内容差异[29],受此启发,Hong等[31]将迁移学习(transferlearning)的方法引入短语音说话人确认系统中,从长时语音训练的模型域学习说话人区分性信息,并将KL正则化项加入到后端PLDA目标函数中,来度量源域和目标域的相似度,实验结果显示该方法有助于提升i-vector-PLDA框架下的短语音说话人确认性能。

3.3基于i-vector和PLDA的说话人确认算法

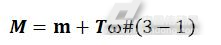

2011年,Dehak在实验中发现,JFA算法[32]假设本征信道空间是利用说话人无关的信道信息估计得到,但实际中部分说话人相关的信息也会泄露至本征信道空间之中,即JFA算法虽然假设利用本征音空间和本征信道空间来区分说话人信息和信道信息,但是无法有效分离两个空间。因此,Dehak不划分征音信道空间和本征音空间,并使用一个全局差异(TotalVariability)空间来统一描述说话人信息和信道信息,并一个全局差异因子(i-vector)描述说话人因子和信道因子[4]。在i-vector说话人确认系统中,说话人超矢量被分解为:

公式中m表示非特定说话人的超矢量;�是低秩的全局差异空间;�是全局差异因子,也称为身份矢量,即i-vector。

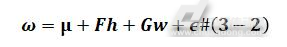

在i-vector方法中,说话人信息和信道信息都包含在全局差异空间中,为了提高i-vector对说话人表征的准确度,需要引入信道补偿技术来进一步消除信道因子的影响,因此,引入PLDA[33]对i-vector做进一步的因子分析,即将i-vector空间进一步分解为说话人空间和信道空间,具体分解如下:

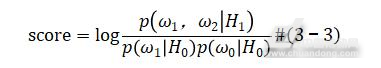

其中,�表示说话人的语音;�是所有训练i-vector的均值;�表示说话人空间矩阵,描述说话人相关特征;�是说话人因子;�是信道空间矩阵,描述同一说话人不同语音之间的差异;�是信道因子;�为噪声因子。此外,�和�满足�(0,1)分布。在测试阶段,通过对数似然比来判断两条语音是否由同一说话人空间的特征生成,其公式如下:

其中ω1,ω2分别为注册和测试阶段的说话人i-vector向量,H0假设两段语音属于不同说话人,H1假设两段语音属于同一个说话人。

4 基于深度学习的时说话人确认主流技术

2013年前,主流的说话人确认技术都是基于统计模型方法。随着深度学习方法在语音识别,图像处理等领域取得突破性进展,学者们开始研究基于深度学习的说话人确认技术。其中主要分支包括:基于深度网络特征学习的说话人确认方法,基于度量学习的说话人确认方法,基于多任务学习的说话人确认方法和端到端的说话人确认方法。

4.1基于深度网络特征提取的方法

基于深度网络的特征学习方法,利用复杂非线性结构赋予的特征提取能力,能自动对输入的语音信号进行特征分析,提取出更高层、更抽象的说话人表征。

2014年,谷歌的研究员Ehsan等人[34]提出了基于DNN(DeepNeuralNetworks,DNN)结构的说话人确认算法,选取最后一层隐藏层激活后的输出作为说话人帧级别特征(frame-levelfeatures);一段语音所有帧级别特征取平均后得到该段语音的句子级特征(utterance-levelfeatures),称之为d-vector;2015年,Chen等人[35]发现输入层到DNN第一个隐藏层间存在权值矩阵过大的问题,将其可视化后,发现存在大量的零值,而非零权值则存在聚集效应,针对这一问题,提出了使用局部连接和卷积网络(ConvolutionalNeuralNetworks,CNN)代替全连接的方法,新网络的参数量下降了30%,且性能仅有4%的损失,此外,在同样多的参数情况下,新网络的EER分别提高了8%和10%;2017年,清华大学的Wang[36]提出了一种CNN和TDNN混合的特征提取网络,输入为语谱图,输出则是具有可分性的说话人表征,由于通过语谱图可以直接获取句子级别的特征,因此网络性能具有较大的提升。2018年,Li等人[37]发现在基于DNN的特征传统提取结构中,由于使用了含有参数的softmax层,可能导致部分说话人信息“泄漏”到了隐层与softmax层连接的权重参数中,导致由最后一层网络节点所表示的深度特征不完备,进而使得准确率较低,因此作者改进了损失函数,使得新的损失函数不含额外参数,说话人全部信息表征均在网络最后一层输出;同年约翰斯霍普金斯大学的Povey[30],提出基于DNN的x-vector说话人确认系统,该系统将语音特征提取过程分为帧级(frame-level)和段级(segment-level),并使用统计池化层连接两级特征。同年Povey[38]发现使用数据增强,在原始语音数据中以一定比例加入噪声、混响、人声等干扰因素,使得网络能够从带噪数据中提炼出有效信息,进而提高说话人确认系统的性能。

4.2基于度量学习的方法

基于度量学习的方法着眼于设计更适合说话人确认任务的目标函数,使得特征提取网络通过新的目标函数能学习到具有较小类内距离、较大类类距离的特征。

2017年,百度提出了DeepSpeaker[39]系统,其使用人脸识别中广泛应用的tripletloss作为损失函数,模型训练时先提取同一说话人两段语音的表征,再提取不同说话人语音的表征,目标是令同一说话人表征之间的余弦相似度高于不同说话人之间的余弦相似度。在文本无关的数据上,EER相比基于DNN的方法降低了50%;2018年,纽约大学的Salehghaffari[40]提出了使用Simaese结构,即使用contrastiveloss作为损失函数,其设计的基于CNN的说话人确认网络较i-vector系统降低了近10%的EER。

4.3基于多任务学习的方法

由于不同语音任务之间存在一定的相似性(如关键词检测与说话人确认,语音分离与语音增强),研究者们尝试通过在相关任务中共享信息,使得模型在说话人确认任务上具有更好的泛化能力,进而提高说话人确认系统的泛化能力。

2018年清华大学的Ding等人[41]将图像生成领域中的TripletGAN迁移到了说话人确认领域,运用多任务学习的思想让网络同时进行说话人确认和语音合成两个任务,使用生成对抗网络(GenerativeAdversarialNetworks,GAN)作为数据生成器,生成更多的语音数据作为说话人确认网络的输入,使其学习到更具泛化能力的说话人表征,相比tripletloss网络性能有较大的提升;同年,Novoselov等人[42],将说话人确认任务和数字识别任务相结合,使得网络最后一层同时输出说话人辨认和语音数字识别结果,在RSR2015数据库上其相比基准算法有近50%的提升;Dey等人[43]则通过数字辨认和说话人确认的多任务学习,使网络能联合优化各个问题,并采用tripletloss作为目标函数,在RSR数据库上较i-vector方法提升了43%。

4.4端到端的说话人确认

端到端的说话人确认系统,输入为不同说话人的语音信号,输出即为说话人确认结果。端到端的网络通常包含大量参数,相比其它基于深度学习的说话人确认方法需要较多的训练与测试数据。

2016年,Google的Heigold等人[44]提出了端到端说话人确认系统,其包含两个网络:预先训练好的特征提取网络和用于决策打分的判决网络。训练阶段,首先利用预训练的特征提取网络获取语音帧级特征,取平均后得到句子级别特征并与其它语句提取出的特征计算余弦相似度;然后将相似度输入逻辑回归层中,其中仅包含权重变量和偏置变量两个标量参数,最终逻辑回归层输出是否为同一说话人;注册阶段,获取输入语音的特征,再次训练整个网络,训练中仅改变逻辑回归层的偏置参数,其他参数保持不变;验证阶段,输入待验证的语音,逻辑回归层直接输出判决结果。2016年微软的Zhang[45]发现静音帧信号对句级别特征的多余贡献会弱化其表征能力,因此提出使用注意力机制,引入两个预训练网络,一个用于获取每一帧语音的音素特征,另一个则判断当前词是否为三音素组,结合两个网络输出赋予每一帧信号不同权重,加权合成句级别特征。2017年Google的Chowdhury改进了注意力机制[46],权重的获取不再依赖预先训练的辅助网络,而是直接对帧级别特征进行非线性变换学习权重参数,这样极大地减少了网络的复杂程度;Google的Li[47]提出用领域自适应的方法,在端到端的说话人确认任务中利用大语料数据集辅助小语料数据集,同时针对文本相关和文本无关两种场景分别设计了两类不同的损失函数,使得网络训练时间减少了60%,准确率提高了10%。

5 总结与展望

本文重点介绍了面向智能语音控制场景下的短语音说话人确认技术,综述了基本概念,分析了短语音说话人确认技术面临的挑战,并从特征提取和短语音建模两个角度介绍了主流方法,最后介绍了基于深度学习的说话人确认技术发展现状。

相比于基于传统机器学习的说话人确认技术,基于深度学习的短语音说话人确认技术性能更佳,这得益于深度网络具有强大的特征提取能力。但是,我们也看到,基于深度学习的方法需要大量的标注训练语音数据进行模型训练,这限制了基于深度学习的说话人确认模型的泛化以及应用推广。因此采用迁移学习方法将基于大语料数据库训练获得的说话人模型迁移到基于小语料数据库的说话人模型、有效地提取短语音中更具区分性的特征以及设计更适合短语音说话人确认任务的目标函数等是未来重点的研究方向。

参考文献

[1]HansenJHL,HasanT.SpeakerRecognitionbyMachinesandHumans:Atutorialreview[J].IEEESignalProcessingMagazine,2015,32(6):74-99.

[2]郑方,李蓝天,张慧,等.声纹识别技术及其应用现状[J].信息安全研究,2016,2(1):44-57.

[3]SchefferN,FerrerL,GraciarenaM,etal.TheSRINIST2010speakerrecognitionevaluationsystem[C]//IEEEInternationalConferenceonAcoustics,SpeechandSignalProcessing.IEEE,2011:5292-5295.

[4]DehakN,KennyPJ,DehakR,etal.Front-EndFactorAnalysisforSpeakerVerification[J].IEEETransactionsonAudioSpeech&LanguageProcessing,2011,19(4):788-798.

[5]MarkelJ,OshikaB,GrayA.Long-termfeatureaveragingforspeakerrecognition[J].IEEETransactionsonAcousticsSpeech&SignalProcessing,1977,25(4):330-337.

[6]K.Li,E.Wrench.Anapproachtotext-independentspeakerrecognitionwithshortutterances[C]//Acoustics,Speech,andSignalProcessing,IEEEInternationalConferenceonICASSP.IEEE,1983:555-558.

[7]ReynoldsDA,QuatieriTF,DunnRB.SpeakerVerificationUsingAdaptedGaussianMixtureModels[C]//DigitalSignalProcessing.2000:19–41.

[8]KennyP.Bayesianspeakerverificationwithheavytailedpriors[C]//Proc.OdysseySpeakerandLanguageRecogntionWorkshop,Brno,CzechRepublic.2010.

[9]PoddarA,SahidullahM,SahaG.Speakerverificationwithshortutterances:areviewofchallenges,trendsandopportunities[J].IetBiometrics,2018,7(2):91-101.

[10]LarcherA,KongAL,MaB,etal.Text-dependentspeakerverification:Classifiers,databasesandRSR2015[J].SpeechCommunication,2014,60(3):56-77.

[11]DasRK,PrasannaSRM.SpeakerVerificationfromShortUtterancePerspective:AReview[J].IeteTechnicalReview,2017(1):1-19.

[12]V.Hautamäki,Y.-C.Cheng,P.Rajan,etal.Minimaxi-vectorextractorforshortdurationspeakerverification[J].2013.

[13]PoorjamAH,SaeidiR,KinnunenT,etal.IncorporatinguncertaintyasaQualityMeasureinI-VectorbasedLanguageRecognition[C]//TheSpeakerandLanguageRecognitionWorkshop.2016.

[14]KanagasundaramA,VogtR,DeanD,etal.i-vectorbasedSpeakerRecognitiononShortUtterances[C]//INTERSPEECH.DBLP,2011.

[15]HosseinzadehD,KrishnanS.OntheUseofComplementarySpectralFeaturesforSpeakerRecognition[J].EurasipJournalonAdvancesinSignalProcessing,2007,2008(1):1-10.

[16]MakhoulJ.Linearprediction:atutorialreview.ProcIEEE63:561-580[J].ProceedingsoftheIEEE,1975,63(4):561-580.

[17]HermanskyH.Perceptuallinearpredictive(PLP)analysisofspeech.[J].JournaloftheAcousticalSocietyofAmerica,1990,87(4):1738-1752.

[18]HuangX,AceroA.SpokenLanguageProcessing:AGuidetoTheory,Algorithm,andSystemDevelopment[M].PrenticeHallPTR,2001.

[19]TodiscoM,DelgadoH,EvansN.ArticulationratefilteringofCQCCfeaturesforautomaticspeakerverification[C]//INTERSPEECH.2018.

[20]LeungKY,MakMW,SiuMH,etal.Adaptivearticulatoryfeature-basedconditionalpronunciationmodelingforspeakerverification[J].SpeechCommunication,2006,48(1):71-84.

[21]KennyP,GuptaV,StafylakisT,etal.DeepneuralnetworksforextractingBaum-Welchstatisticsforspeakerrecognition[C]//Odyssey.2014.

[22]FuT,QianY,LiuY,etal.Tandemdeepfeaturesfortext-dependentspeakerverification[C]//ConferenceoftheInternationalSpeechCommunicationAssociation.InternationalSpeechCommunicationAssociation(ISCA),2014:747-753.

[23]SainathTN,KingsburyB,RamabhadranB.Auto-encoderbottleneckfeaturesusingdeepbeliefnetworks[C]//IEEEInternationalConferenceonAcoustics,SpeechandSignalProcessing.IEEE,2012:4153-4156.

[24]KennyP,StafylakisT,OuelletP,etal.PLDAforspeakerverificationwithutterancesofarbitraryduration[C]//IEEEInternationalConferenceonAcoustics,SpeechandSignalProcessing.IEEE,2013:7649-7653.

[25]JelilS,DasRK,SinhaR,etal.SpeakerVerificationUsingGaussianPosteriorgramsonFixedPhraseShortUtterances[C]//INTERSPEECH.2015.

[26]DeyS,MotlicekP,MadikeriS,etal.Exploitingsequenceinformationfortext-dependentSpeakerVerification[C]//IEEEInternationalConferenceonAcoustics,SpeechandSignalProcessing.IEEE,2017:5370-5374.

[27]KanagasundaramA,DeanD,Gonzalez-DominguezJ,etal.ImprovingShortUtterancebasedI-vectorSpeakerRecognitionusingSourceandUtterance-DurationNormalizationTechniques[C]//Proceed.ofINTERSPEECH.2013:3395-3400.

[28]KanagasundaramA,DeanD,SridharanS,etal.Improvingshortutterancei-vectorspeakerverificationusingutterancevariancemodellingandcompensationtechniques[J].SpeechCommunication,2014,59(2):69-82.

[29]HasanT,SaeidiR,HansenJHL,etal.Durationmismatchcompensationfori-vectorbasedspeakerrecognitionsystems[J].2013:7663-7667.

[30]SnyderD,GhahremaniP,PoveyD,etal.Deepneuralnetwork-basedspeakerembeddingsforend-to-endspeakerverification[C]//SpokenLanguageTechnologyWorkshop.IEEE,2017:165-170.

[31]HongQ,LiL,WanL,etal.TransferLearningforSpeakerVerificationonShortUtterances[C]//INTERSPEECH.2016:1848-1852.

[32]KennyP.Jointfactoranalysisofspeakerandsessionvariability:Theoryandalgorithms[J].2005.

[33]SenoussaouiM,KennyP,BrümmerN,etal.MixtureofPLDAModelsini-vectorSpaceforGender-IndependentSpeakerRecognition[C]//INTERSPEECH2011,ConferenceoftheInternationalSpeechCommunicationAssociation,Florence,Italy,August.DBLP,2011:25-28.

[34]VarianiE,LeiX,McdermottE,etal.Deepneuralnetworksforsmallfootprinttext-dependentspeakerverification[C]//IEEEInternationalConferenceonAcoustics,SpeechandSignalProcessing.IEEE,2014:4052-4056.

[35]ChenY,Lopez-MorenoI,SainathTN,etal.Locally-connectedandconvolutionalneuralnetworksforsmallfootprintspeakerrecognition[C]//SixteenthAnnualConferenceoftheInternationalSpeechCommunicationAssociation.2015.

[36]LiL,ChenY,ShiY,etal.DeepSpeakerFeatureLearningforText-independentSpeakerVerification[J].2017:1542-1546.

[37]LiL,TangZ,WangD,etal.Full-infoTrainingforDeepSpeakerFeatureLearning[J].2018.

[38]SnyderD,Garcia-RomeroD,SellG,etal.X-vectors:RobustDNNembeddingsforspeakerrecognition[J].ICASSP,Calgary,2018.

[39]LiC,MaX,JiangB,etal.DeepSpeaker:anEnd-to-EndNeuralSpeakerEmbeddingSystem[J].2017.

[40]HosseinSalehghaffari,etal.SpeakerVerificationusingConvolutionalNeuralNetworks[J].2018

[41]DingW,HeL.MTGAN:SpeakerVerificationthroughMultitaskingTripletGenerativeAdversarialNetworks[J].2018.

[42]NovoselovS,KudashevO,SchemelininV,etal.DeepCNNbasedfeatureextractorfortext-promptedspeakerrecognition[J].2018.

[43]SDey,TKoshinaka,PMotlicek,SMadikeri,etal,DNNbasedspeakerembeddingusingcontentinformationfortext-dependentspeakerverification[J].2018

[44]HeigoldG,MorenoI,BengioS,etal.End-to-endtext-dependentspeakerverification[C]//Acoustics,SpeechandSignalProcessing(ICASSP),2016IEEEInternationalConferenceon.IEEE,2016:5115-5119.

[45]ZhangSX,ChenZ,ZhaoY,etal.End-to-endattentionbasedtext-dependentspeakerverification[C]//SpokenLanguageTechnologyWorkshop(SLT),2016IEEE.IEEE,2016:171-178.

[46]ChowdhuryFA,WangQ,MorenoIL,etal.Attention-basedModelsforText-DependentSpeakerVerification[J].arXivpreprintarXiv:1710.10470,2017.

[47]WanL,WangQ,PapirA,etal.Generalizedend-to-endlossforspeakerverification[J].arXivpreprintarXiv:1710.10467,2017.

QQ交流群

QQ交流群